A mesterséges intelligencia adatéhsége

A mesterséges intelligencia fejlesztésében élen járó cégek, mint az OpenAI, szembesülnek azzal a problémával, hogy hamarosan kifogynak azokból az adatokból, amelyekkel a modelleiket tanítják. A Wall Street Journal szerint a jó minőségű szöveges adatok, mint tudományos publikációk és Wikipédia szócikkek, az elkövetkező másfél évben teljesen elfogyhatnak.

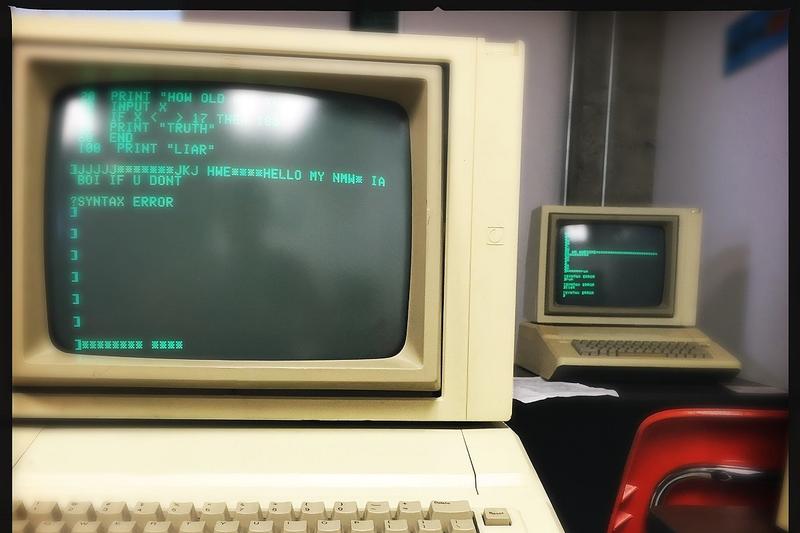

A mesterséges intelligencia modellek tanítása hasonlít a gyermekek tanulási folyamatához: minél többet "olvasnak", annál "okosabbak" lesznek. A fejlesztőknek ezért szükségük van nagy mennyiségű megbízható szöveges információra, amit feldolgoznak és mintázatokat keresnek benne a nyelvi struktúrák felismerése érdekében. A vezető nyelvi modelleket eddig körülbelül háromezer milliárd szó segítségével tanították be.

A technológiai óriások, mint az OpenAI és a Google, új adatszerzési módszereket keresnek, hogy fenntarthassák növekedési terveiket. Az OpenAI például YouTube videók hanganyagából készít írott szöveges tartalmat, ami szerzői jogi problémákat vet fel. A Google, amely a YouTube anyavállalata, hasonló módszereket alkalmaz, és eddig nem lépett fel az ilyen gyakorlatok ellen.

A Facebook anyavállalata, a Meta, a Simon & Schuster kiadó felvásárlását fontolgatja, hogy hozzáférjen a könyvekben található információkhoz. Sy Damle, szerzői jogi ügyvéd szerint a nyelvi AI modellek gyakorlati megvalósításának egyetlen módja, ha hatalmas mennyiségű adaton taníthatók anélkül, hogy azt licenszelni kellene.

A szintetikus adatok előállítása is felmerült megoldásként. Az AI modellek így saját maguk által generált szövegeken edződhetnének, de ez negatív ciklusokhoz vezethet, ahol a modellek a saját hibáikat erősítik meg. Az OpenAI kísérletezik azzal, hogy két különböző modell tanítja egymást, hogy elkerüljék ezt a problémát. A módszer megbízhatóságát illetően a kutatók véleménye megoszlik, de a cég vezetője, Sam Altman bizakodó.