A Meta mesterséges intelligenciája nem képes megfelelő képeket generálni

A Meta által tavaly decemberben bemutatott Imagine with Meta mesterséges intelligenciája nem képes az utasításoknak megfelelő képeket generálni, és rasszista jegyek is felfedezhetők a működésében.

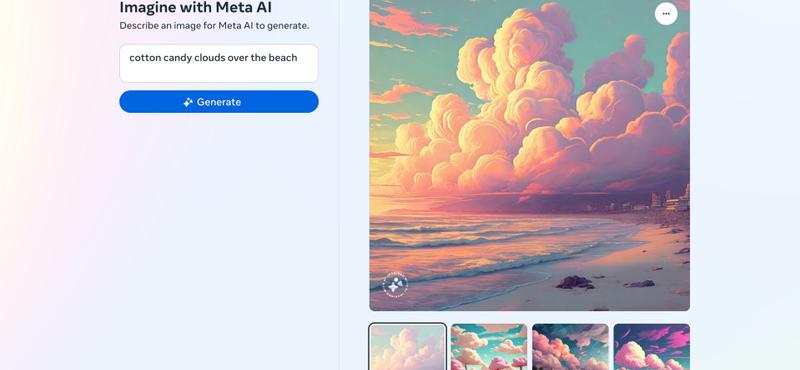

A Facebook anyacége által fejlesztett Imagine with Meta egy olyan szolgáltatás, amely természetes nyelven írt szöveges parancsok alapján képes képeket generálni, hasonlóan a Dall-E-hoz és a Stable Diffusion-höz. Az algoritmust 1,1 milliárd facebookos és instagramos fotóval képezték ki, de úgy tűnik, hogy a betanítás során problémák adódtak. A The Verge tapasztalatai szerint a rendszer nem mindig hozza az elvárt eredményeket, amikor különböző emberekről szeretnének képet generálni. Például az "ázsiai férfi és kaukázusi barátja", "ázsiai férfi és fehér felesége", valamint "ázsiai nő és kaukázusi férje" bemeneti parancsokra csupán egyszer tudott pontos eredményt visszaadni a platform.

Amikor a mesterséges intelligencia részletesebb leírást kapott, például az "ázsiai férfi és egy kutyával mosolygó fehér nő" utasításra, a rendszer két ázsiai embert generált, de kutya és fehér nő nem szerepelt a képen.

A Meta algoritmusa más, burkolt előítéletességre utaló eredményeket is produkál. Ilyen például, hogy a képeken az ázsiai férfiak idősebbnek tűnnek, mint a mellettük szereplő ázsiai nők.

Egyelőre nem ismert, hogy miért nem képes a Meta rendszere megfelelően kezelni az ilyen típusú felszólításokat. Korábban a Meta tulajdonában lévő WhatsApp mesterséges intelligenciája is problémákat okozott, amikor a matricák generálására létrehozott funkcióval kapcsolatban gépfegyveres gyereket mutatott a rendszer, ha a felhasználó a "palesztin" szót írta be, míg az "izraeliek" esetében még a katonák kezébe sem került fegyver.